加速原生创新 奋进智能时代

原生开发产业开发者生态伙伴

发表于 2024/07/06

原生开发产业开发者生态伙伴

发表于 2024/07/06

去年,我们共同探讨大模型时代的智能根基,今年,我们又齐聚在这里,共同探索如何加速大模型创新与应用落地的道路。

昇腾AI在产业界和学术界的支持下加速发展,生态已经走向了原生驱动。4年前,我们与教育部合作,启动了智能基座项目,首次将昇腾和昇思作为教学课程带入大学校园。今天,第一批以昇腾和昇思作为人工智能启蒙的学生即将毕业,走向工作岗位,未来必将成长为中国AI原生创新的中坚力量。

今年3月份,我们启航了昇腾原生计划,呼吁更多原生力量的加入。截至目前,在原生技术生态上,我们已经累计培养了30多万昇腾原生的学生,有3万多原生贡献者累计提交了9.5万代码合入请求,联合伙伴/客户核心开发者原生打造了80多个融合大算子;原生商业生态上,目前,我们已发展了50多家APN伙伴,孵化了20多个原生大模型以及50多个大模型应用,共同探索大模型在行业场景的实践。

回顾过去十年,人工智能从5年1迭代到3年1迭代到每年1迭代,每次迭代都带动了诸多行业变革。我相信,与大家一起,必将使能千行万业,奋进计算的黄金时代。

Scaling Law仍在持续,驱动大模型的能力演进,对算力提出了更高的要求,但是,大规模并不等于大算力,集群能够发挥的有效算力与规模并非线性增长,卡间通信的损耗、网络吞吐的下降以及系统可用度的下降都会导致有效算力的增长速度无法匹配大模型算力需求的快速增长。我们需要领先的智算集群,来突破有效算力,驱动大模型发展!

结合与众多伙伴及客户的实践经验,我们认为:

领先的智算集群首先需要具备无收敛组网下线性的算力扩展能力,让每一张卡发挥最大的计算能力;同时,需要具备大规模并行下极致的算力利用能力,让大模型能够充分发挥算力集群的能力;最后,需要具备在系统全负荷工作下不间断的稳定运行能力,让训练任务持续健康、快速地迭代。领先的智算集群将成为驱动人工智能通往AGI的基础动力

2023年是大模型训练的元年,经过一年的迅速发展,基础大模型能力越来越强,并在C端和B端开始落地。今年我们将迎来大模型推理的元年,推理应用数量迎来了爆发式的增长,头部企业加速布局,快速获取用户流量。我们处在这个机会涌现的时代,为了把握时机,加入应用落地,我们需要迅速行动,围绕业务需求构建领先的、先发优势的推理系统。

大模型的推理系统我认为需要满足以下三点核心能力:

大模型技术的快速演进需要开放易用的开发体系,包括:提供一套兼顾性能与易用性的统一架构,并同时满足应用、模型以及算法等多场景开发需求,还需具备贡献反馈的开放能力,使能深度优化、提供先进算法、沉淀创新经验,实现开发体系的持续发展。

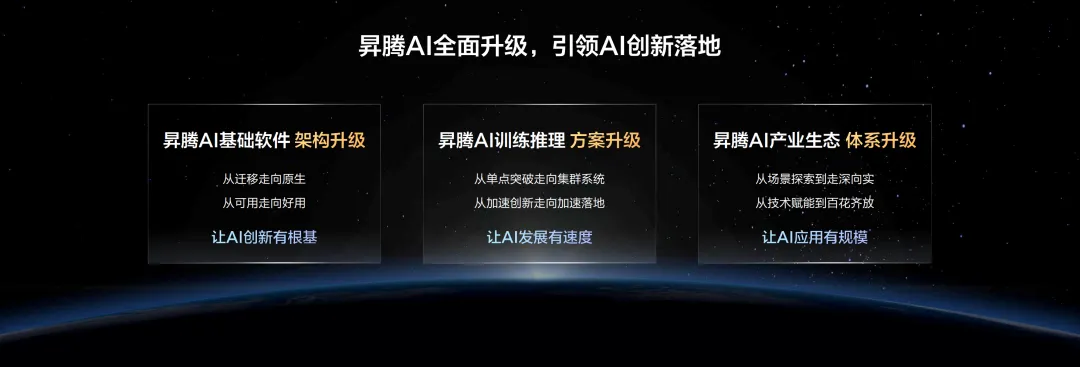

为了更好地推动人工智能面向当前大模型时代的发展,昇腾AI将围绕三大方面持续突破并全面升级,加速AI创新落地:

2020年,我们围绕硬件使能、AI框架和应用使能,初步构建了昇腾AI的基础软硬件。4年来,我们坚持聚焦根技术的创新,并结合业界的建议和反馈,不断迭代和演进各能力组件,应对不同时期的需求和挑战。今天,面向大模型时代,我们全面升级昇腾AI基础软件架构!

我们不仅升级了CANN、昇思、MindStudio工具链,以更好地满足大算子/大模型的开发和调优需求,同时新增了MindSpeed分布式加速套件、MindIE推理引擎、知识增强 SDK、CCAE集群自智引擎,来加速大模型的训练、推理和应用开发。

通过全新的昇腾AI基础软件,实现一套原生开发体系完成算子、模型、应用三种开发场景;一套协同开发软件架构兼顾开发性能与易用性;一套全域管理平台覆盖集群系统所涉及的计算、网络、存储的管理运维。

昇腾AI基础软件栈一直秉承分层开放的策略,每一层都支撑了客户和伙伴不同场景的原生开发。

面对日益深入的加速技术需求,我们将异构计算架构CANN的能力开放,提供Ascend C接口类库及算子加速库,今年5月,我们进一步开放了集合通信库以及GE图引擎接口,让开发者获得更灵活、更深度的开发能力。目前,已经支撑头部客户自主开发了100+满足业务场景的高性能算子;

面对与日俱增的大模型分布式优化需求,我们提供了MindSpeed分布式加速套件,提供序列并行、内存碎片优化、选择性重计算等丰富的加速算法,支持开发者直接调用以及二次开发,让客户能够在昇腾的算法之上,基于业务模型结构及设备规模开展更专业、更深入的算法开发,目前,已经支撑了20多家伙伴及客户的原生算法创新;

昇腾AI软件栈将持续保持开放,为更多的伙伴和客户提供技术基础和原生创新灵感。

昇腾训练解决方案从设计之初,就围绕集群构建竞争力,我们坚信大模型和集群是未来发展趋势。我们基于大模型技术发展方向及业务需求,自上而下原生设计,结合华为在ICT领域计算、网络、存储积累的丰富经验,持续升级,打造大规模、高效率、长稳定的智算集群系统,为客户提供了极具竞争力的产品解决方案。

伴随集群规模演进,通过NLSB网络负载均衡技术解决多场景负载不均、吞吐下降问题,整网有效吞吐从50%提升到95%以上,集群规模可线性扩展。

规模的扩展带来更多的通信损耗,因此,对分布式并行效率提出了更高的要求。我们通过MindSpeed分布式训练加速套件提供丰富的大模型分布式并行算法及并行策略,在计算、通信以及内存等方面深度优化,提高计算效率,在有效训练时长里获得最大的计算能力。

在大规模和高效率的能力基础之上,集群的稳定性也决定了大模型训练的整体效率,为此,我们提供了CCAE自智引擎,让集群管理从“单域”走向“全域”:

这些关键能力的提升帮助我们将长稳训练时间从周级提升到月级。

为了更好地匹配大模型的推理需求,我们秉承分层开放、快速部署的原则,重点在运行时、模型套件和服务化等能力上,全面升级昇腾推理解决方案,支持客户和伙伴在文本生成、视图生成等场景下高效完成高性能应用的开发和部署。同时在推理系统能力上不断追求极致:

生态一直是昇腾AI发展的初衷和核心,我们坚定围绕“原生”,每年投入专项资金,以“技术+商业”双轮驱动生态繁荣。

面向技术生态,通过培养布道师,体系化赋能开发者。过去在生态发展初期,我们主要以昇腾自有团队为主,通过激励来单点牵引高校、科研院所、企业和个人开发者,覆盖的人群、范围、场景都有所限制,能力也主要聚焦在昇腾的迁移适配上。

今年,昇腾有了一批具备原生开发能力的核心开发者,尤其是互联网、实验室的中坚力量,我们将这些技术大咖都培养成了昇腾的布道师,他们以专业的技术影响力,辐射更多的人群。真正做到以开发者为核心,从点到线、连线成网的体系化发展技术生态。

面向商业生态,通过发展双模式,协同伙伴拓展行业场景。产业初期我们主要聚焦在重点行业重点客户拓展,主要的合作模式是昇腾先发现场景,我们基于对行业的理解后再联系伙伴进行适配开发,最后,再以昇腾和伙伴协同,拓展客户。

现在,我们的伙伴深耕细分场景,对于场景有了更深刻的理解,我们通过赋能伙伴基于昇腾原生开发出更有竞争力的产品和方案,以伙伴为主进行拓展,我们做好支撑赋能客户。

这两种合作模式共同存在,一方面助力伙伴更深入的理解行业,另一方面赋能伙伴打造更匹配场景需求的产品,真正支撑伙伴商业成功,加速AI规模应用。

产业聚集人才,人才引领创新,高校则是人才培养的摇篮。去年,智能基座项目走向2.0,持续深化产教融合与科教融合,强化面向学生的原生实践活动。今年,我们还将率先联合一批头部高校,共建昇腾科教创新卓越中心与孵化中心,通过前沿技术合作、创新课题资助、顶级专业竞赛等,培养一批昇腾AI卓越研究人才。

高校学生是产业的未来,而开发者则代表了产业当下。这几年,我们一直围绕“学、练、训、赛”成长路径,深入培养开发者,这些优秀的AI人才,都已成为中国AI产业发展的中坚力量。

去年,我们首次发布了昇腾伙伴计划APN,行业伙伴纷纷加入,贡献智慧,促进昇腾生态快速发展。如今,我们的伙伴数量已经突破50家,基于昇腾部件,开发了100多种满足专业场景的多样化的推理产品,为企业提供有竞争力的解决方案,覆盖越来越多的行业场景。

今年,迅龙科技基于昇腾推出的香橙派AI开发板,让开发者能够快速上手、开箱即用,当前已服务了超过3万个人及企业开发者;英码科技基于昇腾AI推出的边缘智能硬件,已经在河南、广东、江西等多地园区得到规模部署,服务于园区智能巡检等场景,平均缩短了50%以上的园区安全管理时间;思腾合力基于昇腾推出的推理服务器,已在北京、杭州等多个城市规模部署,服务于交通治理场景,平均提升交通管理效率30%以上。

未来,相信在昇腾与伙伴的共同努力下,必将会为大家推出更加多样化的产品和服务,将人工智能带入丰富的行业场景,让智能无所不及。

得力于大家的支持,过去几年来,我们也一直联合产业界的伙伴和客户不断探索,开发更多能够服务于工作、生活和产业的可落地方案和应用。如今,AI应用场景逐步走深向实,推动和加速AI与行业场景深度融合。可以看到,我们的伙伴已经有大量的方案和应用融入到了激发创新,改善生活和赋能产业的场景中,促进人工智能真正服务于我们的工作和生活。

结合昇腾与大客户和伙伴的实践,我们也总结了《2024昇腾AI20大应用场景》,欢迎大家下载。

【长按扫码下载】

大模型已经掀起了智能时代的新篇章,对于智能时代的发展前景,任何假设都是保守的,预测未来的最好方式就是创造未来!让我们携手,加速原生创新,奋进智能时代!

上一篇

下一篇