由于支持x86_64和Arm平台、NPU的标卡和模组等多种场景的混合部署,所以需要给各个工作节点配置标签,便于集群调度组件在各种不同形态的工作节点之间进行调度。

用户可以通过配置标签的方式指定任务运行的节点。标签配置涉及Job(任务)、volcano-scheduler和Node(节点),且三处的标签需要进行匹配(即在Job配置的标签能够在volcano-scheduler和Node中找到),如自定义标签配置所示。

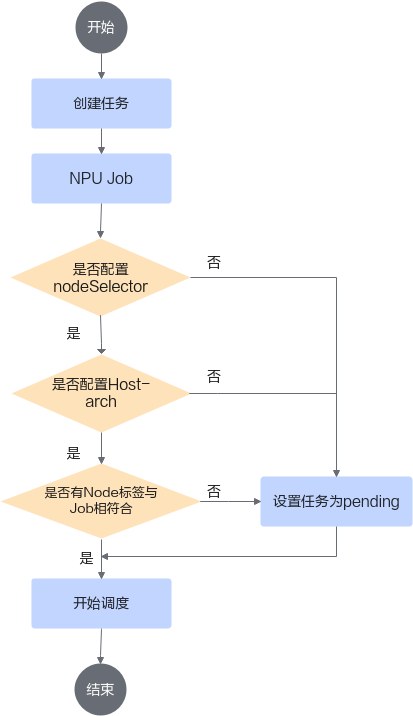

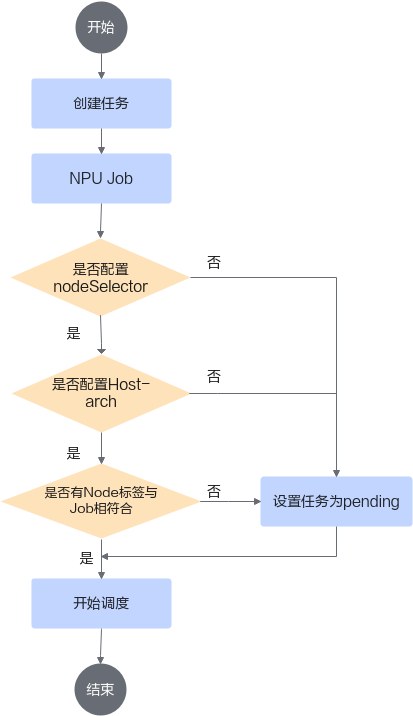

图1 自定义标签流程

- NPU类型的Job必须配置host-arch的nodeSelector标签,内容默认为huawei-arm或huawei-x86,修改无效。

- 若Job配置了标签,则首先需要与volcano-scheduler配置的标签相匹配。若不匹配,则任务设置为pending状态,并给出原因。若匹配则进行下一步。

- Job的标签在volcano-scheduler的标签列表中,volcano-scheduler需要选出配置有同样标签的Node。若不满足则Job设置为pending状态,并给出原因。若有则按照其他规则进行调度。

自定义volcano-scheduler标签

在MindCluster Volcano部署文件“volcano-v{version}.yaml”中,对如下“configurations”中“name”为“selector”的部分进行配置,需要配置到“arguments”中。

...

data:

volcano-scheduler.conf: |

actions: "enqueue, allocate, backfill"

tiers:

- plugins:

- name: priority

- name: gang

- name: conformance

- name: volcano-npu_v5.0.0.2_linux-aarch64 # 其中v5.0.0.2为MindX DL的版本号,根据不同版本,该处编码不同。

- plugins:

- name: drf

- name: predicates

- name: proportion

- name: nodeorder

- name: binpack

configurations:

- name: selector

arguments: {"host-arch":"huawei-arm|huawei-x86",

"accelerator":"huawei-Ascend910|nvidia-tesla-v100|nvidia-tesla-p40",

"accelerator-type":"card|module|half|module-{xxx}b-16|module-{xxx}b-8|card-{xxx}b-2","servertype":"soc"}

...

- 配置方式为map格式,目前仅支持英文输入。若一个标签存在多个值的情况,请使用“|”进行分割。

- 在NPU任务中MindCluster Ascend Device Plugin取值为“Ascend910”时,在“arguments”中"host-arch":"huawei-arm|huawei-x86"为默认配置,修改无效。若用户需要使用其他标签,请自行添加。

- host-arch为huawei-arm|huawei-x86,不配置或修改,都只对NPU任务生效。

- accelerator-type:card、module和half为Atlas 训练系列产品使用的标签;module-{xxx}b-16、module-{xxx}b-8和card-{xxx}b-2为Atlas A2 训练系列产品使用的标签。

自定义任务标签

用户根据需要在训练任务的yaml文件中添加自定义标签,完整的yaml文件请从MindXDL-deploy仓库中下载。其中NPU类型的任务必须包括:host-arch:huawei-arm或host-arch:huawei-x86的nodeSelector标签,其他类型不做限制。

yaml文件的相关配置如下。

...

spec:

containers:

...

nodeSelector:

accelerator: nvidia-tesla-v100

volumes:

...

自定义节点标签

节点的标签需要在装有K8s的管理节点上操作。

- 创建节点标签

kubectl label nodes {HostName} {label_key}={label_value}

参数说明:

- HostName:需要添加的主机名称。

- label_key和label_value需要与Job、volcano-scheduler中的配置相匹配。

例如:kubectl label nodes ubuntu accelerator=nvidia-tesla-p40

- 修改节点标签

kubectl label nodes {HostName} {label_key}={label_value} --overwrite=true例如:kubectl label nodes ubuntu accelerator=vidia-tesla-p40 --overwrite=true

- 删除节点标签

kubectl label nodes {HostName} {label_key} -例如:kubectl label nodes ubuntu accelerator -