简介

概述

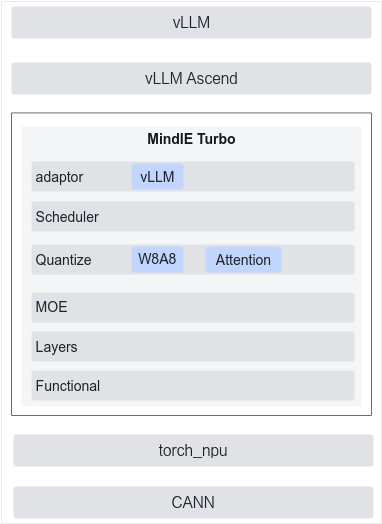

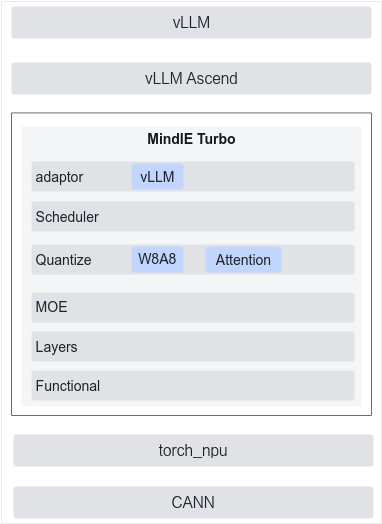

MindIE Turbo是由华为在昇腾硬件上开发的LLM推理引擎加速插件库,包含了自研的大语言模型优化算法和与推理引擎框架相关的优化。MindIE Turbo会提供一系列模块化与插件化的接口,使能三方推理引擎接入并加速。

MindIE Turbo架构

图1 MindIE Turbo架构

功能特性

量化:MindIE Turbo已经支持MindStudio自研的W8A8和W8A8QuantAttention算法。通过MindStudio量化后的模型,可以直接在vLLM上通过MindIE Turbo一键使能。

算子优化:MindIE Turbo针对部分算子,接入了该算子的高性能版本,提升该算子的下发与执行性能,使用vLLM Ascend时MindIE Turbo会自动对对应的算子进行patch操作,使能高性能算子。

支持框架

vLLM:vLLM是伯克利大学LMSYS组织开源的大语言模型高速推理框架,旨在极大地提升实时场景下语言模型服务的吞吐量与内存使用率,提供易用、快速、低成本的LLM服务。目前MindIE Turbo已经支持通过vLLM Ascend一键叠加到vLLM框架并进行推理加速使能。

使用场景

MindIE Turbo是华为自研的性能插件,其中包含了大量自研优化算法,目前支持对vLLM的适配。通过对接vLLM+vLLM-Ascend,能提供更强的性能和更多推理优化量化算法。

实际使用时,只需要在对应Python环境内安装MindIE Turbo,在执行vLLM的过程中,MindIE Turbo会自动检测vLLM并使能,对vLLM、vLLM Ascend的部分接口实现进行替换,不需要修改任何代码即可完成性能优化。