MindIE是什么

MindIE(Mind Inference Engine,昇腾推理引擎)是华为昇腾针对AI全场景业务的推理加速套件。通过分层开放AI能力,支撑用户多样化的AI业务需求,使能百模千态,释放昇腾硬件设备算力。向上支持多种主流AI框架,向下对接不同类型昇腾AI处理器,提供多层次编程接口,帮助用户快速构建基于昇腾平台的推理业务。

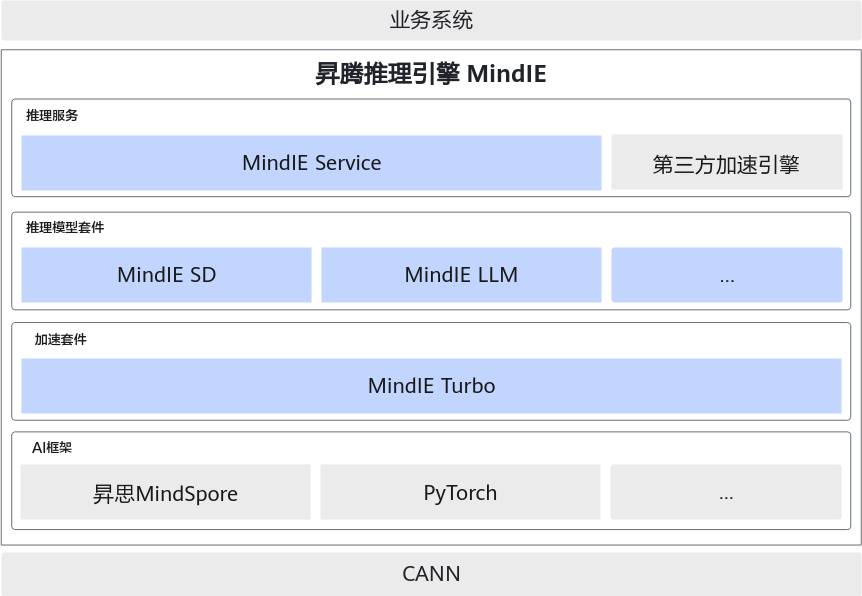

总体架构

MindIE提供了基于多种AI场景下的推理解决方案,具有强大的性能、健全的生态,帮助用户快速开展业务迁移、业务定制。MindIE架构图如图1所示,主要组件介绍如表1所示。

名称 |

说明 |

|---|---|

MindIE Service |

MindIE Service针对通用模型的推理服务化场景,实现开放、可扩展的推理服务化平台架构,支持对接业界主流推理框架接口,满足大语言模型的高性能推理需求。MindIE Service包含MindIE MS、MindIE Server、MindIE Client和MindIE Benchmark四个子组件。

MindIE Service向下调用了MindIE LLM组件能力。 |

MindIE SD |

MindIE SD是MindIE解决方案下的多模态生成推理框架组件,其目标是为多模态生成系列大模型推理任务提供在昇腾硬件及其软件栈上的端到端解决方案,软件系统内部集成各功能模块,对外呈现统一的编程接口。 |

MindIE LLM |

MindIE LLM是针对大模型优化推理的高性能SDK,包含深度优化的模型库、大模型推理优化器和运行环境,提升大模型推理易用性和性能。 |

MindIE Turbo |

MindIE Turbo是昇腾为所有推理引擎提供的通用昇腾硬件加速套件,在内存、通信、编解码等层面上提供加速,达到更大的吞吐、更低的时延。目前首发版本支持了vLLM的加速,其他引擎加速敬请期待。 |

MindIE Torch |

MindIE Torch对接PyTorch框架,提供PyTorch模型推理加速能力。PyTorch框架上训练的模型利用MindIE Torch提供的简易C++/Python接口,少量代码即可完成模型迁移,实现高性能推理。 |

关键功能特性

- 服务化部署

提供用户侧接口、调度优化、多模型业务串流等能力。提供模型管理,DevOps等服务化调度能力,详情请参见《MindIE Service开发指南》。

- 多模态生成

支持SD模型迁移推理,高效实现应用部署,场景化落地SD应用,满足客户精度及性能要求,详情请参见《MindIE SD开发指南》。

- 大模型推理

提供大模型推理能力,支持大模型业务全流程,逐级能力开放,使能大模型客户需求定制化,详情请参见《MindIE LLM开发指南》。

- 推理引擎加速插件库

在昇腾硬件上开发的LLM推理引擎加速插件库,包含了自研的大语言模型优化算法和与推理引擎框架相关的优化。提供一系列模块化与插件化的接口,使能三方推理引擎接入并加速,详情请参见《MindIE Turbo开发指南》。

- PyTorch模型迁移(当前能力构建中)

对接主流PyTorch框架,实现训练到推理的平滑迁移,提供通用的图优化并行推理能力,提供用户深度定制优化能力,详情请参见《MindIE Torch开发指南》。