总体说明

Client推理模式在运行前,需要启动MindIE Server的Endpoint服务。

使用以下命令启动MindIE Server Endpoint服务。

cd $MIES_INSTALL_PATH/ ./bin/mindieservice_daemon

显示如下则说明启动成功。

Daemon start success!

Client推理模式运行时,会调用MindIE Client相应的接口向MindIE Server Endpoint发送推理请求并进行打点统计。

Client推理模式支持传递采样参数和惩罚系数,采样参数和惩罚系数均存于参数--SamplingParams参数中。--DoSampling通过Benchmark透传,会在MindIE LLM侧控制是否使--SamplingParams中的采样参数生效。

client推理模式下,并发数为影响性能(吞吐量及平均Decode时间)的关键指标,根据用户的不同需求,初步选取标准如下:

- 提高系统吞吐量(QPS):适当提高并发数。

- 提高系统的平均非首token时间:随着并发数增大,非首token的Decode时间会增加,卡非首token时间时可以设定一个较小的并发数,baichuan2-13b并发数参考设定为64或更小的数值(卡50ms平均Decode时间),LLaMA-65B及类似大小模型的参考并发数为16/32。

此外,Endpoint启动前还需要根据模型权重计算合适的npuMemsize以获得最佳性能,具体配置方法请参见性能调优流程。

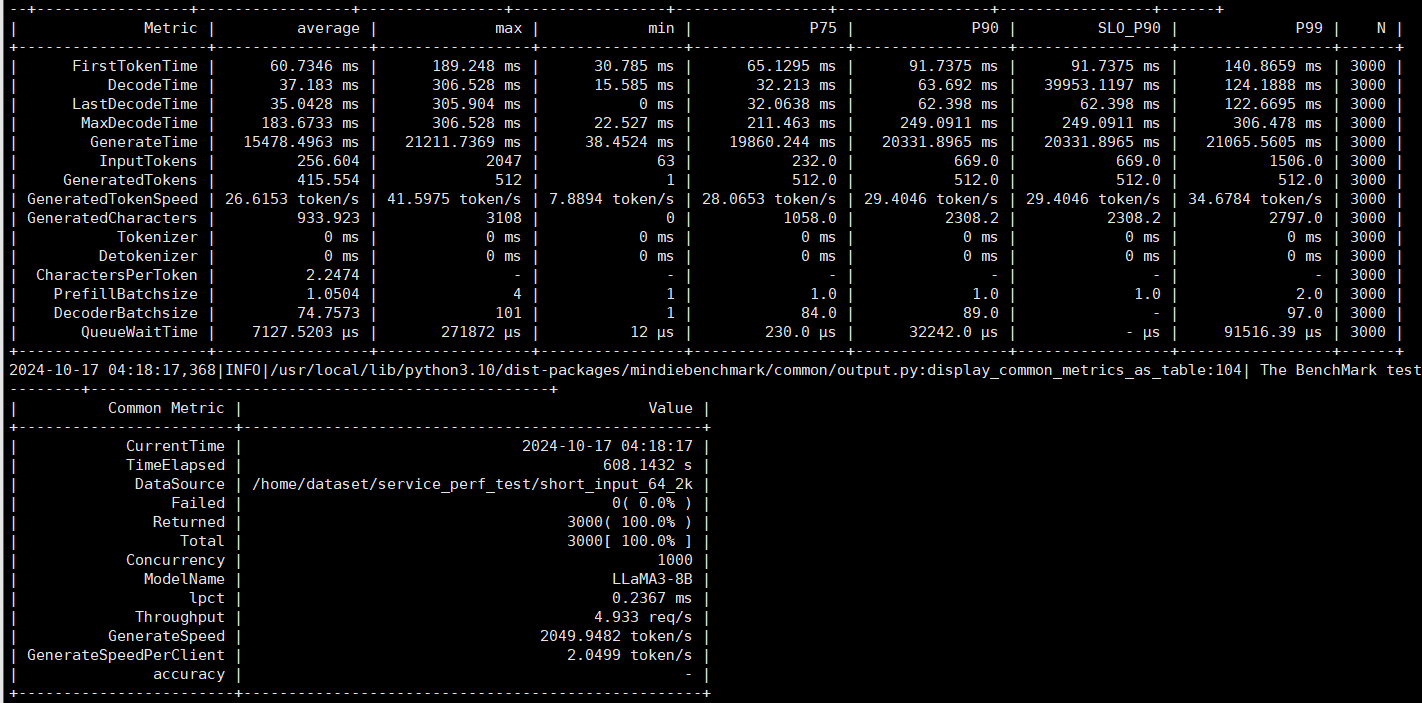

Client推理模式输出结果如图1所示:

父主题: Client推理模式