vLLM简介

vLLM是一个为大语言模型提供高吞吐量和内存高效推理服务的开源引擎,使用PageAttention技术高效实现注意力Key和Value的内存管理,并且支持包括量化模型推理、Multi-LoRA、投机推理和SplitFuse等众多推理特性。作为一个Python编写的开源大语言模型推理框架,vLLM因其易用性与高效性得到了广泛的应用。

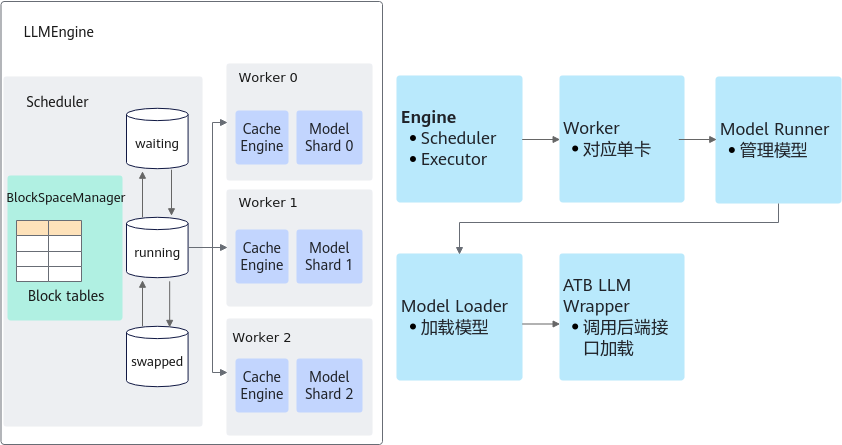

vLLM框架适配昇腾整体方案介绍

vLLM框架在昇腾环境适配的整体方案为上层运行vLLM框架原生的逻辑,包括请求调度、Batch组建、Ray分布式拉起多卡服务等;下层模型推理与后处理通过MindIE LLM提供的GeneratorTorch统一接口接入MindIE模型仓统一进行管理,实现加速库整图模式的模型推理加速。

vLLM框架下层模型推理对接Text Generator接口的基本方式为实例化Text Generator中的GeneratorTorch类,继而通过该类的实例对象的forward_tensor和sample函数分别去使用MindIE LLM的模型推理和后处理功能。

支持版本特性与模型

|

支持的vLLM版本 |

浮点 |

量化 |

SplitFuse |

LoRA |

多模态 |

|---|---|---|---|---|---|

|

0.3.3 |

同MindIE LLM |

同MindIE LLM |

- |

同MindIE LLM |

- |

|

0.4.2 |

同MindIE LLM |

同MindIE LLM |

同MindIE LLM |

同MindIE LLM |

Qwen-VL |