功能说明

对输入tensor做LogSoftmax计算。计算公式如下,其中PAR表示矢量计算单元一个迭代能够处理的元素个数 :

为方便理解,通过python脚本实现的方式表达计算公式如下,其中src是源操作数(输入),dst、sum、max为目的操作数(输出)。

def log_softmax(src):

#基于last轴进行rowmax(按行取最大值)处理

max = np.max(src, axis=-1, keepdims=True)

sub = src - max

exp = np.exp(sub)

#基于last轴进行rowsum(按行求和)处理

sum = np.sum(exp, axis=-1, keepdims=True)

dst = exp / sum

dst = np.log(dst)

return dst, max, sum

实现原理

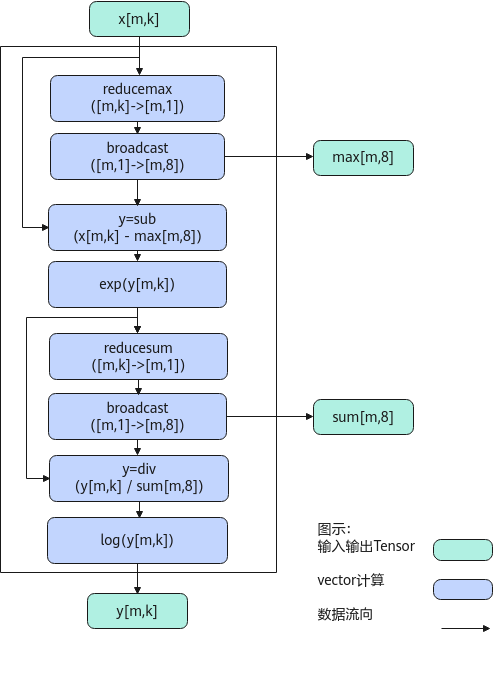

以float类型,ND格式,shape为[m, k]的输入Tensor为例,描述LogSoftMax高阶API内部算法框图,如下图所示。

计算过程分为如下几步,均在Vector上进行:

- reducemax步骤:对输入x的每一行数据求最大值得到[m, 1],计算结果会保存到一个临时空间temp中;

- broadcast步骤:对temp中的数据([m, 1])做一个按datablock为单位的填充,比如float类型下,把[m, 1]扩展成[m, 8],同时输出max;

- sub步骤:对输入x的所有数据按行减去max;

- exp步骤:对sub之后的所有数据求exp;

- reducesum步骤:对exp后的结果的每一行数据求和得到[m, 1],计算结果会保存到临时空间temp中;

- broadcast步骤:对temp([m, 1])做一个按datablock为单位的填充,比如float类型下,把[m, 1]扩展成[m, 8],同时输出sum;

- div步骤:对exp结果的所有数据按行除以sum;

- log步骤:对div后的所有数据按行做log计算,输出y。

函数原型

1 2 |

template <typename T, bool isReuseSource = false, bool isDataFormatNZ = false> __aicore__ inline void LogSoftMax(LocalTensor<T>& dst, const LocalTensor<T>& sumTensor, const LocalTensor<T>& maxTensor, const LocalTensor<T>& src, const LocalTensor<uint8_t>& sharedTmpBuffer, const LogSoftMaxTiling& tiling, const SoftMaxShapeInfo& softmaxShapeInfo = {}) |

由于该接口的内部实现中涉及复杂的数学计算,需要额外的临时空间来存储计算过程中的中间变量。临时空间支持开发者通过sharedTmpBuffer入参传入。临时空间大小BufferSize的获取方式如下:通过LogSoftMax Tiling中提供的接口获取空间范围的大小。

参数说明

|

参数名 |

描述 |

|---|---|

|

T |

操作数的数据类型。 |

|

isReuseSource |

是否允许修改源操作数。该参数预留,传入默认值false即可。 |

|

isDataFormatNZ |

源操作数是否为NZ格式。默认值为false。 |

|

参数名 |

输入/输出 |

描述 |

|---|---|---|

|

dst |

输出 |

目的操作数。 类型为LocalTensor,支持的TPosition为VECIN/VECCALC/VECOUT。 Atlas A2训练系列产品/Atlas 800I A2推理产品,支持的数据类型为:half/float Atlas推理系列产品AI Core,支持的数据类型为:half/float |

|

src |

输入 |

源操作数。 类型为LocalTensor,支持的TPosition为VECIN/VECCALC/VECOUT。 源操作数的数据类型需要与目的操作数保持一致。 Atlas A2训练系列产品/Atlas 800I A2推理产品,支持的数据类型为:half/float Atlas推理系列产品AI Core,支持的数据类型为:half/float |

|

sharedTmpBuffer |

输入 |

临时缓存。临时空间大小BufferSize的获取方式请参考LogSoftMax Tiling。 类型为LocalTensor,支持的TPosition为VECIN/VECCALC/VECOUT。 |

|

maxTensor |

输出 |

reduceMax操作数。 reduceMax操作数的数据类型需要与目的操作数保持一致。 类型为LocalTensor,支持的TPosition为VECIN/VECCALC/VECOUT。 Atlas A2训练系列产品/Atlas 800I A2推理产品,支持的数据类型为:half/float Atlas推理系列产品AI Core,支持的数据类型为:half/float |

|

sumTensor |

输出 |

reduceSum操作数。 reduceSum操作数的数据类型需要与目的操作数保持一致。 类型为LocalTensor,支持的TPosition为VECIN/VECCALC/VECOUT。 Atlas A2训练系列产品/Atlas 800I A2推理产品,支持的数据类型为:half/float Atlas推理系列产品AI Core,支持的数据类型为:half/float |

返回值

无

支持的型号

Atlas A2训练系列产品/Atlas 800I A2推理产品

Atlas推理系列产品AI Core

约束说明

- 输入源数据需保持值域在[-2147483647.0, 2147483647.0]。若输入不在范围内,输出结果无效。

- 不支持源操作数与目的操作数地址重叠。

- 不支持sharedTmpBuffer与源操作数和目的操作数地址重叠。

- 操作数地址偏移对齐要求请参见通用约束。

调用示例

//DTYPE_X、DTYPE_A、DTYPE_B、DTYPE_C分别表示源操作数、目的操作数、maxLocal、sumLocal操作数数据类型

pipe.InitBuffer(inQueueX, BUFFER_NUM, totalLength * sizeof(DTYPE_X));

pipe.InitBuffer(outQueueA, BUFFER_NUM, totalLength * sizeof(DTYPE_A));

pipe.InitBuffer(outQueueB, BUFFER_NUM, outsize * sizeof(DTYPE_B));

pipe.InitBuffer(outQueueC, BUFFER_NUM, outsize * sizeof(DTYPE_C));

pipe.InitBuffer(tmpQueue, BUFFER_NUM, tmpsize);

AscendC::LocalTensor<DTYPE_X> srcLocal = inQueueX.DeQue<DTYPE_X>();

AscendC::LocalTensor<DTYPE_A> dstLocal = outQueueA.AllocTensor<DTYPE_A>();

AscendC::LocalTensor<DTYPE_B> maxLocal = outQueueB.AllocTensor<DTYPE_B>();

AscendC::LocalTensor<DTYPE_C> sumLocal = outQueueC.AllocTensor<DTYPE_C>();

AscendC::SoftMaxShapeInfo softmaxInfo = {outter, inner, outter, inner};

AscendC::LocalTensor<uint8_t> tmpLocal = tmpQueue.AllocTensor<uint8_t>();

AscendC::LogSoftMax<DTYPE_X, false>(dstLocal, maxLocal, sumLocal, srcLocal, tmpLocal, softmaxtiling, softmaxInfo);

输入数据(srcLocal): [0.80541134 0.08385705 0.49426016 ... 0.30962205 0.28947052] 输出数据(dstLocal): [-0.6344272 -1.4868407 -1.0538127 ... -1.2560008 -1.2771227]