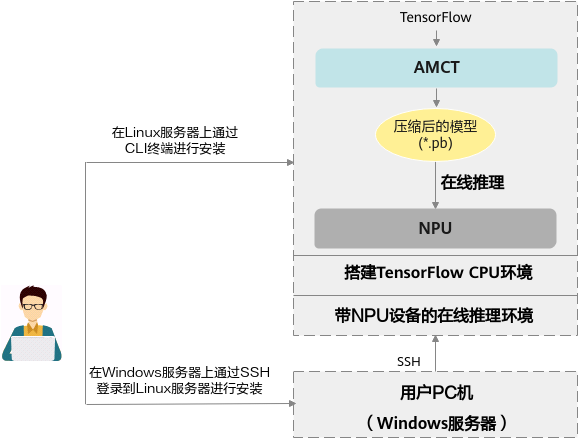

基于TF_Adapter的TensorFlow网络模型量化,量化后的模型支持在NPU以及CPU进行推理,其部署架构图如图1所示。本手册仅介绍量化后的模型在NPU推理的场景。

- 用户需要先在带NPU设备的在线推理环境上搭建TensorFlow CPU环境,然后在该环境上安装AMCT,进行模型压缩,生成压缩后的*.pb模型。

AMCT进行量化时(本手册主要是训练后量化),需要借助带NPU的设备进行校准推理。

- 压缩后的*.pb模型,可以在NPU环境进行在线推理,也可以基于TensorFlow CPU环境完成精度仿真。