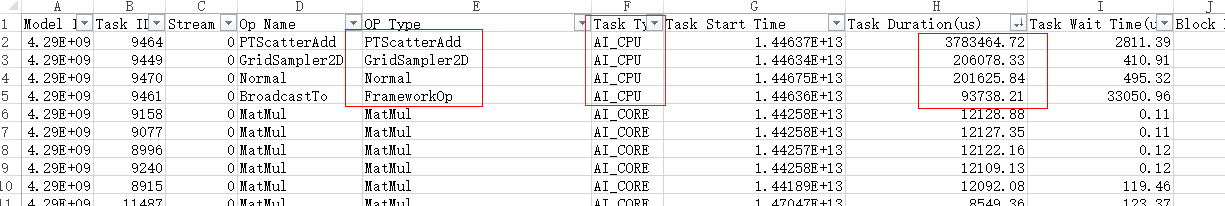

- 通过Profiling结果数据op_summary文件(./result/PROF_***/device_0/summary/op_summary_***.csv文件)分析调度任务执行时间,排查算子耗时。

图1 高耗时算子

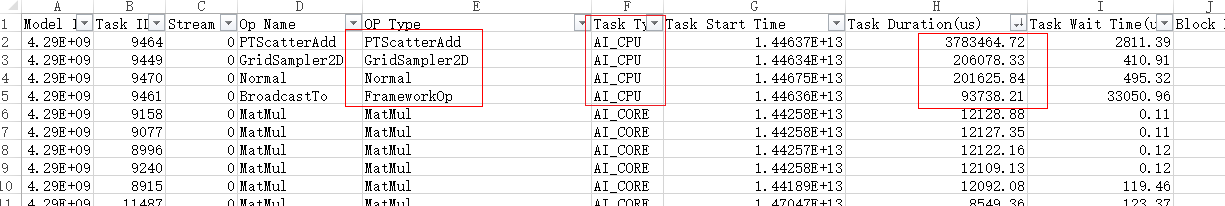

- 通过Profiling结果数据op_summary文件(./result/PROF_***/device_0/summary/op_summary_***.csv文件)分析算子类型。

图2 AI CPU算子

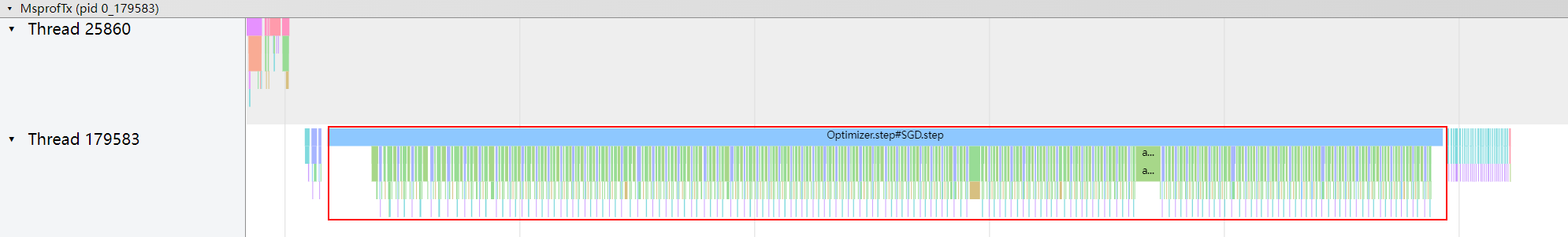

- 在Chrome浏览器中输入“chrome://tracing”地址,将timeline文件夹中的总表msprof*.json文件拖到空白处打开。查看梯度更新函数部分的算子情况,发现有大量小算子被引入,导致算子下发耗时长,影响性能。

图3 梯度更新部分的小算子

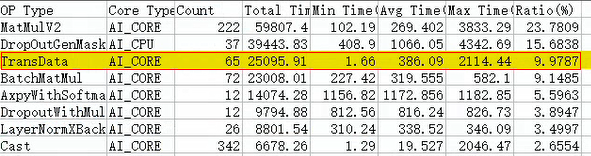

- 通过Profiling结果数据op_statistic_文件(./result/PROF_***/device_0/summary/op_statistic_***.csv文件)分析算子调用总时间,排查是否算子总耗时较长。按照Total Time排序,分析转换类算子是否耗时占比较大,如TransData、Cast。样例分析步骤如下。

- 查看op_statistic.csv文件中算子耗时,发现TransData算子耗时排在第三位。结果如下。

图4 转换类算子耗时

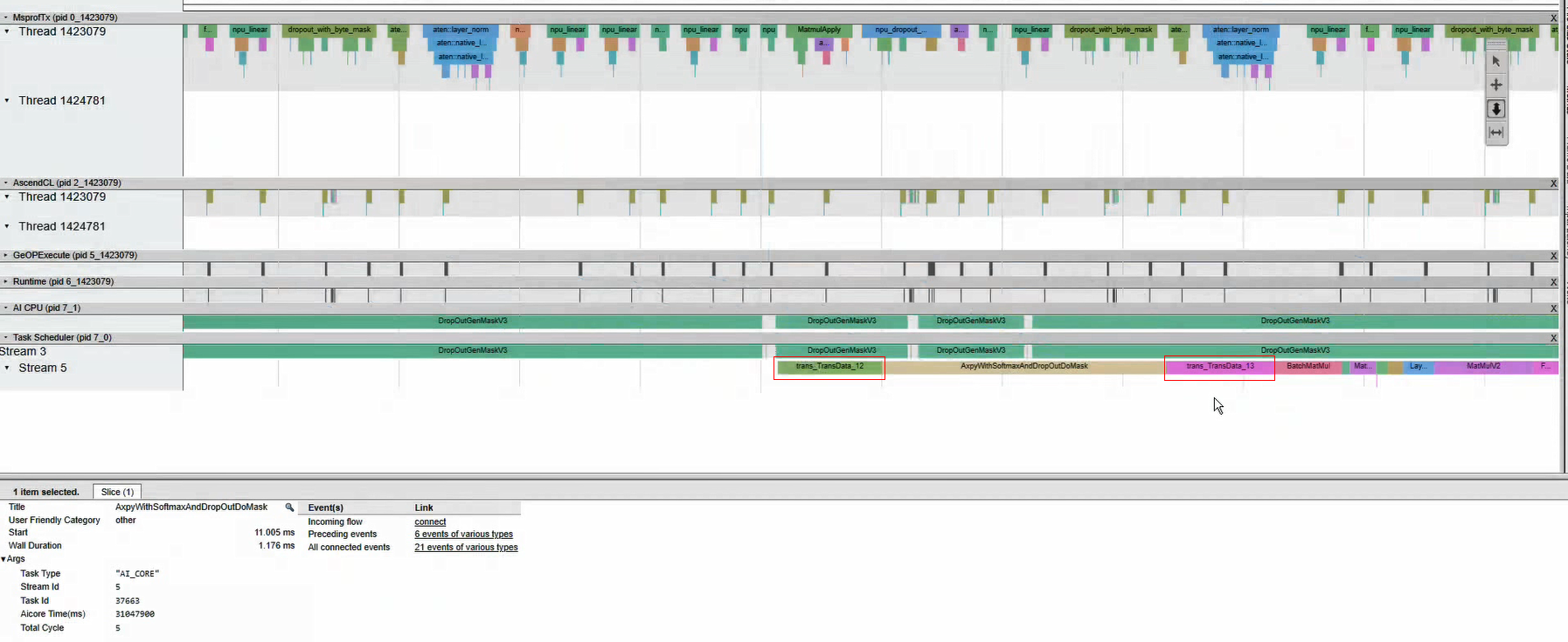

- 分析msprof.json文件,发现TransData算子经常出现在AxpyWithSoftmaxAndDropOutDoMask算子两侧,由此可推断AxpyWithSoftmaxAndDropOutDoMask算子的输入不符合它需要的格式,因此会自动插入TransData算子进行转换。Timeline示例图如下。

图5 Timeline示例

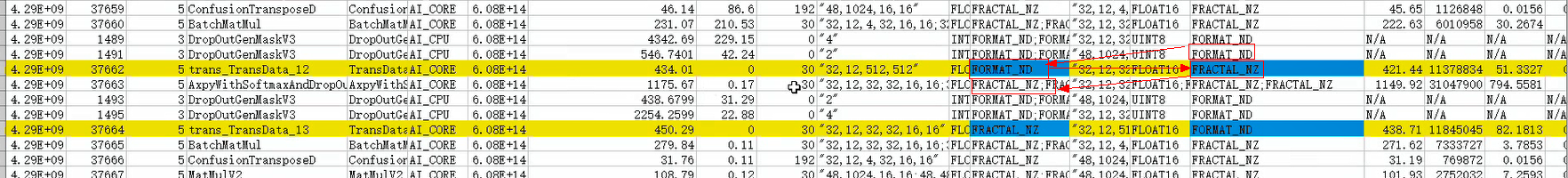

- 在op_summary.csv文件中对Task Start Time进行排序,找到排序后的AxpyWithSoftmaxAndDropOutDoMask算子,发现其要求的输入格式为FRACTAL_NZ,但是上一算子输出的格式为FORMAT_ND,因此需要使用TransData算子对格式进行转换,可以认为是格式转换耗时长影响了性能。算子信息如下。

图6 算子信息

- 查看op_statistic.csv文件中算子耗时,发现TransData算子耗时排在第三位。结果如下。

采集数据说明

PyTorch性能数据采集生成的数据文件汇总如下。各数据文件详细文件介绍请参见《性能分析工具》。

timeline文件名 |

说明 |

|---|---|

msprof*.json |

timeline数据总表。对采集到的timeline性能数据按照迭代粒度进行性能展示。 |

ai_stack_time_*.json |

各个组件(AscendCL,GE,Runtime,Task Scheduler)的耗时。 |

thread_group_*.json |

AscendCL,GE,Runtime组件耗时数据。该文件内的各组件数据按照线程(Thread)粒度进行排列,方便查看各线程下各组件的耗时数据。当模型为动态Shape时自动采集并生成该文件。 |

task_time_*.json |

Task Scheduler任务调度信息。 |

acl_*.json |

AscendCL接口耗时数据。 |

runtime_api_*.json |

Runtime接口耗时数据。 |

task_queue.json |

msproftx数据,通过采集E2E profiling数据采集,需在PyTorch训练脚本内设置“use_e2e_profiler=True”。 |

timeline文件名 |

说明 |

|---|---|

msprof_tx.json |

msproftx timeline数据。对采集到的host msproftx timeline数据按线程进行拼接,并进行数据关联性展示。 |

msprof*.json |

timeline数据总表。对采集到的timeline性能数据按照迭代粒度进行性能展示。 |

summary文件名 |

说明 |

|---|---|

op_summary_*.csv |

AI Core和AI CPU算子信息。 |

op_statistic_*.csv |

AI Core和AI CPU算子调用次数及耗时,从算子类型维度找出耗时最大的算子类型。 |

ai_stack_time_*.csv |

每个组件(AscendCL,GE,Runtime,Task Scheduler)的耗时。 |

runtime_api_*.csv |

每个runtime api的调用时长。 |

task_time_*.csv |

Task Scheduler的任务调度信息数据。 |

ge_op_execute_*.csv |

算子下发各阶段耗时数据。当模型为动态Shape时自动采集并生成该文件。 |

acl_*.csv |

AscendCL接口的耗时。 |

acl_statistic_*.csv |

AscendCL接口调用次数及耗时。 |

prof_rule_0.json |

调优建议。 |

summary文件名 |

说明 |

|---|---|

pytorch_operator_view.csv |

msproftx数据,通过采集E2E profiling数据采集,需在PyTorch训练脚本内设置“use_e2e_profiler=True”。 |

msprof_tx.csv |

msproftx summary数据。对采集到的host msproftx summary数据按线程进行拼接,并进行数据关联性展示。 |