本节介绍使用AMCT工具的具体流程,不同框架运行环境以及流程会有稍许差异。

PyTorch/ONNX/TensorFlow/Caffe场景

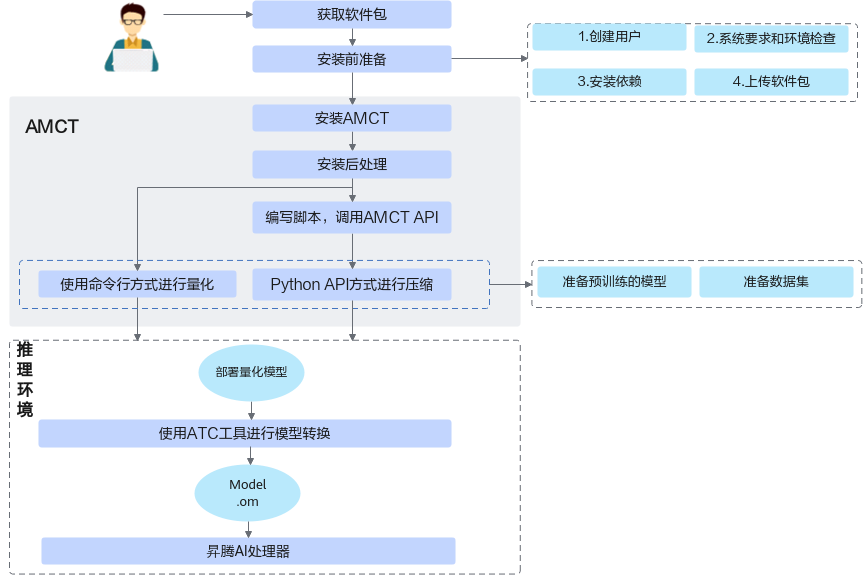

具体运行流程如图1所示。

关键步骤 |

说明 |

|---|---|

获取软件包 |

安装前请先获取对应软件包,详情请参见获取软件包。 |

安装前准备 |

安装AMCT之前,需要创建AMCT的安装用户,检查系统环境是否满足要求,安装依赖以及上传软件包等一系列动作。详细操作请参见安装前准备。 不同框架环境配置不同,请参见对应框架进行操作。 |

安装 |

参见安装安装AMCT工具,不同框架安装命令不同,请参见对应框架安装步骤进行操作。 |

安装后处理 |

安装完AMCT后,需要参见安装后处理章节执行相关操作,没有该章节的框架,则忽略此步骤。 |

(可选)编写脚本,调用AMCTAPI |

如果使用AMCT提供的sample进行模型压缩,则可以直接调用本手册中的API; 如果用户需要压缩自己的网络模型,不使用本手册提供的sample链接进行压缩,则需要修改压缩脚本,进行适配,然后才能进行压缩。 |

压缩 |

执行压缩操作。 关于量化特性,AMCT提供了两种量化方法,命令行方式量化和调用Python API接口方式,两种方式详细区别请参见表1。

用户根据准备的原始网络模型以及数据集,采用本手册提供的量化脚本或者命令行,进行量化。 AMCT是基于深度学习框架进行开发的,在执行压缩过程中需要调用深度学习框架进行必要的推理或训练过程。 |

(后续处理)压缩后模型的推理 |

用户使用上述压缩后的部署模型,通过ATC工具转换成适配昇腾AI处理器的离线模型,然后可以使用该模型进行推理。 |

TensorFlow,Ascend场景

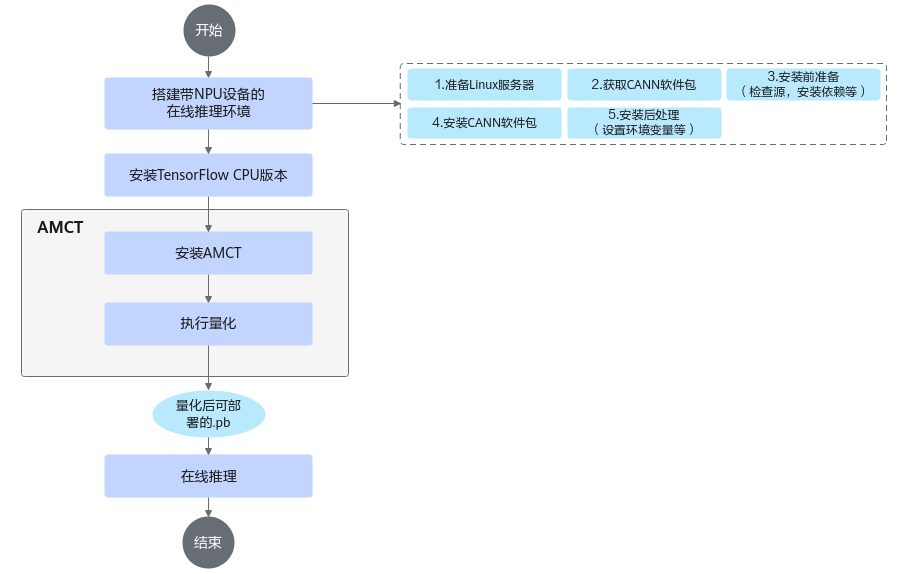

该场景仅限

关键步骤 |

说明 |

|---|---|

搭建带NPU设备的在线推理环境 |

参见如下步骤搭建带NPU设备的在线推理环境。

|

安装TensorFlow CPU版本 |

在线推理环境只支持基于NPU的量化,不支持GPU量化,故只需安装TensorFlow CPU版本。详细安装步骤请参见AMCT(TensorFlow,Ascend)。 |

安装AMCT |

参见安装安装TensorFlow框架的AMCT。安装之前需要完成获取软件包,创建AMCT安装用户、环境检查、安装依赖、上传软件包等一系列准备动作。 |

(可选)编写脚本,调用AMCTAPI |

如果使用AMCT提供的sample进行模型压缩,则可以直接调用本手册中的API; 如果用户需要压缩自己的网络模型,不使用本手册提供的sample链接进行压缩,则需要修改压缩脚本,进行适配,然后才能进行压缩。 |

量化 |

用户根据准备的原始网络模型以及数据集,采用本手册提供的量化脚本,进行量化。 AMCT是基于深度学习框架进行开发的,在执行量化过程中需要调用深度学习框架进行必要的推理过程。 |

(后续处理)量化后模型的推理 |

量化后的.pb模型可以在NPU环境进行在线推理业务。在线推理详细操作请参见《TensorFlow 1.15模型迁移指南》或《TensorFlow 2.6.5模型迁移指南》手册,用户根据实际使用的TensorFlow版本选择对应的参考手册。 |