基于MindStudio量化工具的 DeepSeek-V3.2-Exp W8A8 混合量化实践

发表于 2025/10/09

2025 年 9 月 29 日,DeepSeek 正式发布并开源实验性大模型DeepSeek-V3.2-Exp,核心亮点在于引入DeepSeek 稀疏注意力(DSA)机制,重新定义大模型效率标准。

MindStudio工具快速支持

MindStudio 量化工具已完成对接,支持 DeepSeek-V3.2-Exp W8A8 混合量化

针对 DeepSeek-V3.2-Exp 的架构创新,MindStudio 量化工具 msModelSlim 迅速适配,目前已实现模型接入与 W8A8 混合量化能力。不同于常规量化方案, msModelSlim 特别设计分层量化逻辑,并融合 Flex Smooth Quant 离群值抑制算法,在确保精度损失<1% 的前提下,单卡完成量化,大幅减少模型量化资源占用。

核心量化策略

分层量化 + 离群值抑制,精度损失<1%

为平衡 “压缩效率” 与 “精度损失”,msModelSlim针对 DeepSeek-V3.2-Exp 设计专项量化策略:

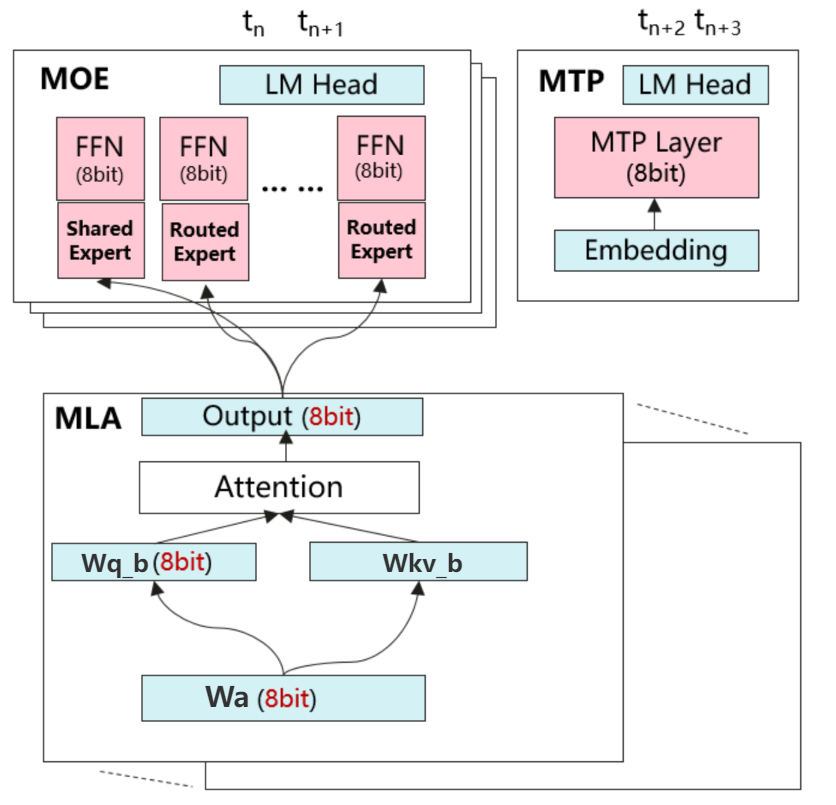

1、分层量化适配:自注意力层采用 “非对称 per-tensor 激活量化 + 对称 per-channel 权重量化”,适配注意力权重分布特性;MLP 层用 “对称 per-token 动态激活量化 + 对称 per-channel 权重量化”,应对复杂特征映射需求。

2、精度优化措施:通过 Flex Smooth Quant 对 Norm-Linear、OV 子图做离群值平滑;排除 kv_b_proj、wq_b 等量化敏感层,保留 BF16 精度;同时针对模型 62 层架构与 MTP机制调优,最终实现量化质量评分优异,且精度损失<1%。

图1 DeepSeek-V3.2-Exp W8A8混合量化策略示意图

工具使用

一键量化!一条命令搞定全流程

目前 DeepSeek-V3.2-Exp 在 msModelSlim中已支持一键量化能力,用户无需复杂配置,仅需执行量化命令,即可完成包含 MTP 机制的 W8A8 混合量化全流程,大幅降低技术使用门槛,助力开发者快速上手部署。

msmodelslim quant \

--model_path ${model_path} \

--save_path ${save_path} \

--model_type DeepSeek-V3.2-Exp \

--quant_type w8a8 \

--trust_remote_code True获取msModelSlim量化工具:

https://gitcode.com/Ascend/msit/tree/master/msmodelslim

我们在魔乐社区上已提供W8A8的量化权重可供开发者直接获取:

https://modelers.cn/models/Modelers_Park/DeepSeek-V3.2-Exp-w8a8

欢迎各位开发者上手试用!