基于香橙派AI Studio的ChatGLM3聊天机器人

发表于 2025/07/25

1.引言

本案例基于香橙派AI Studio 176T 48GB扩展坞,集成MindSpore NLP开源套件,部署ChatGLM3模型,构建端侧聊天机器人,实现低延迟实时对话功能。本案例的实验环境请参考在线课程:《开箱实测OrangePi AI Studio》

2.实验环境

硬件配置:

| 配件名称 | 描述 | 规格要求 |

|---|---|---|

| 香橙派AI Studio | 提供AI算力 | - 算力:176 TOPS INT8 - 内存:48GB/96GB |

| 电脑主机 | 运行系统并连接香橙派 | - x86_64架构 - 16线程+ CPU - 64GB+内存 - USB4/雷电4(支持PCIe隧道,40Gbps) - 系统:Ubuntu 22.04(Linux 5.15内核) |

| USB4数据线 | 连接香橙派和电脑 | - 40Gbps带宽 - 雷电4兼容 - 支持PCIe隧道 |

| 显示器、鼠标、键盘、HDMI连接线 | 连接电脑,提供人机交互 | - HDMI显示器 - USB键鼠 |

系统环境:

| 名称 | 版本 |

|---|---|

| Ubuntu系统 | 22.04.5-desktop-amd64 |

| Ascend-cann-toolkit | 8.0.0.beta1 |

| Ascend-cann-kernels-310* | 8.0.0.beta1 |

| Ascend-mindxsdk-mxvision | 6.0.0.SPC1 |

| python3 | 3.10.12 |

| MindSpore | 2.5.0 |

| MindNLP | 0.4.1 |

请参考在线课程:《开箱实测OrangePi AI Studio》,完成上述软件环境的安装。

3.实验步骤

3.1 ChatGLM3测试案例

步骤 1 确认MindNLP的版本

su root

pip show mindnlp | grep Version输出:

Version: 0.4.1步骤 2 配置CANN环境变量

source /usr/local/Ascend/ascend-toolkit/set_env.sh步骤 3 进入样例目录

cd /data/mindnlp/llm/inference/chatglm3/步骤 4 运行案例代码

首次运行会自动下载模型到当前案例的“.mindnlp”文件夹内。

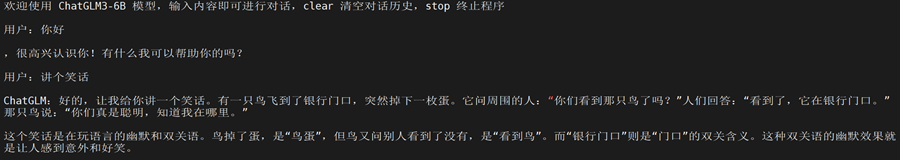

python3 cli_demo.py步骤 5 使用 ChatGLM3-6B 模型

成功启动后,会打印使用说明“欢迎使用 ChatGLM3-6B 模型,输入内容即可进行对话,clear 清空对话历史,stop 终止程序”。我们可以输入clear来清除之前的对话内容,我们在使用完成后,可以输入stop来退出程序。